گوگل برای دسترسی به محتوای سایتهای اینترنتی مراحلی مثل خزش، ایندکس و رندر کردن صفحات وب را انجام میدهد. بسیاری از مواقع لازم است که دسترسی خزنده گوگل را مشخص کنیم و بودجه خزش وب سایت خود را مدیریت کنیم. فایل robots.txt با همین هدف طراحی شده است. با ما همراه باشید تا شما را با استانداردهای فایل robots.txt آشنا کنیم.

فایل robotx.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که به خزندههای موتورهای جستجو (مانند گوگل) میگوید که کدام صفحات وب سایت شما را میتوانند بخزند و کدام صفحات را نباید بخزند.

فایل robots.txt میتواند به شما کمک کند تا کنترل بیشتری بر نحوه خزش و ایندکس شدن سایت خود توسط موتورهای جستجو داشته باشید. به عنوان مثال، میتوانید از فایل robots.txt برای جلوگیری از خزش صفحاتی استفاده کنید که حاوی اطلاعات خصوصی یا حساس هستند.

مراحل خزش، ایندکس و رندر کردن صفحات در گوگل چگونه است؟

هنگامی که کاربر یک عبارت جستجو را در گوگل تایپ میکند، گوگل ابتدا باید صفحات وب مرتبط با آن عبارت را پیدا کند. این فرآیند "خزش" نامیده میشود. خزندههای گوگل از فایل robots.txt برای تعیین اینکه کدام صفحات را باید بخزند، استفاده میکنند. اگر یک صفحه وب در فایل robots.txt مسدود شده باشد، خزندههای گوگل آن صفحه را نمیخزند.

پس از خزش یک صفحه توسط خزندههای گوگل، آن صفحه در پایگاه داده ایندکس میشود. این بدان معناست که گوگل اطلاعاتی در مورد آن صفحه، مانند عنوان، متن و کلمات کلیدی آن را ذخیره میکند.

هنگامی که کاربر یک عبارت جستجو را در گوگل تایپ میکند، گوگل از پایگاه داده خود برای یافتن صفحاتی که حاوی آن عبارت هستند، استفاده میکند. سپس، گوگل صفحاتی را که بیشترین ارتباط را با عبارت جستجو دارند، در نتایج جستجو نمایش میدهد.

نهایتا گوگل در موج دوم ایندکسینگ، خروجی صفحات وب را از طریق مرورگر render میکند تا مطمئن شود که صفحات به طور مناسب برای کاربران نمایش داده میشود و سرعت و تجربه کاربری مناسبی را ایجاد میکند.

نکته مهم: فایل robots.txt دسترسی خزنده گوگل را محدود میکند و ارتباطی به مراحل ایندکس و render ندارد. بنابراین اگر روباتهای ایندکس گوگل، به محتوای یک صفحه از طریق نقشه سایت یا موارد دیگر دسترسی پیدا کنند، ایجاد محدودیت در robotst.txt از ایندکس شدن این صفحات جلوگیری نخواهد کرد.

نحوه استفاده از فایل robots.txt

برای استفاده از فایل robots.txt، باید آن را در دایرکتوری ریشه سایت خود قرار دهید. فایل robots.txt باید با پسوند .txt باشد.

فایل robots.txt از دو دستور اصلی استفاده میکند:

- disallow: این دستور به خزندههای گوگل میگوید که نباید صفحه یا دستهای از صفحات را خززند.

- allow: این دستور به خزندههای گوگل میگوید که باید صفحه یا دستهای از صفحات را خززند.

مثالهایی از نحوه استفاده از دستورات disallow و allow:

برای جلوگیری از خزش همه صفحات در یک دسته، میتوانید از دستور disallow استفاده کنید.

disallow: /category/

برای جلوگیری از خزش یک صفحه خاص، میتوانید از دستور disallow با یک URL خاص استفاده کنید.

disallow: /page.html

برای اجازه دادن به خزش همه صفحات در یک دسته، میتوانید از دستور allow استفاده کنید.

allow: /category/

برای اجازه دادن به خزش یک صفحه خاص، میتوانید از دستور allow با یک URL خاص استفاده کنید.

allow: /page.html

نکاتی برای استفاده از فایل robots.txt

فایل robots.txt را به دقت بررسی کنید تا مطمئن شوید که به خزندههای گوگل اجازه میدهید تا صفحات مهم سایت شما را خزش کنند. همچنین دقت کنید که دسترسی به مشاهده تصاویر، فایل های جاوا اسکریپت و CSS در این فایل محدود نشده باشد. همچنین می توانید آدرس نقشه سایت خودتان را در انتهای این فایل قراردهید تا روباتهای گوگل نقشه سایت را نیز مشاهده و خزش کنند.

اگر مطمئن نیستید که چگونه از فایل robots.txt استفاده کنید، میتوانید از یک متخصص سئو کمک بگیرید.

تست فایل robots.txt از طریق سرچ کنسول

فایل robots.txt مشخص می کند چه مطالبی از سایت توسط خزنده ی گوگل دیده شوند، ایجاد فایل robots.txt ای که به درستی مطالب را مشخص کند و بخش های غیر مطلوب سایت را به خوبی پوشش دهد کار ساده ای نیست، به همین دلیل بسیاری از ساختن این فایل سر باز می زنند. گوگل وبمستر تولز با ارائه robots.txt testing tool این کار را برای افراد آسان ترکرده است.

شما می توانید ابزار تست robots.txt را از طریق سرچ کنسول مشاهده کنید:

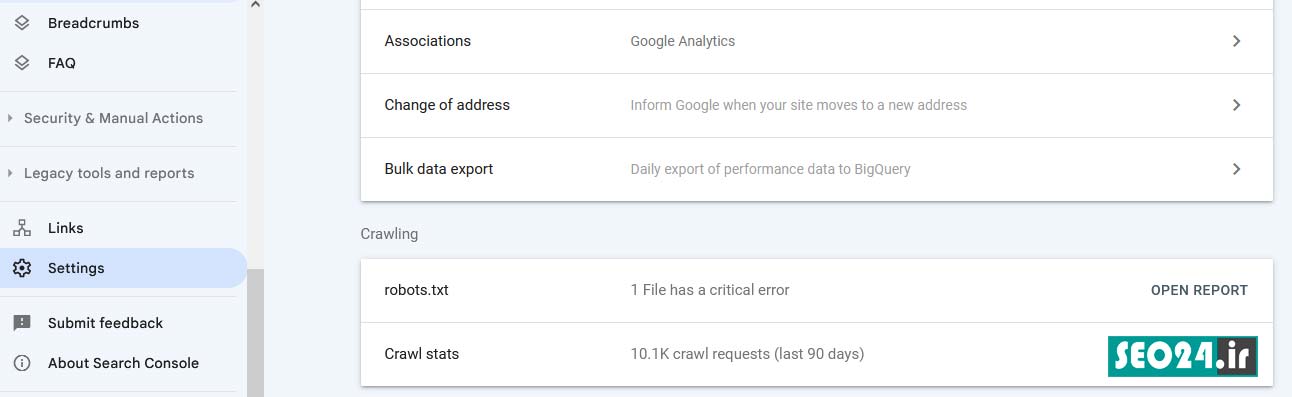

Search Console > Settings > robots.txt > open report

در این بخش شما می توانید فایلی که تحت عنوان robots.txt وجود دارد را بررسی کرده و آدرس هایی که فعال هستند و خزنده می تواند آنها را بیابد پیدا کنید. برای راهنمایی بهتر در مورد دستور العمل های پیچیده بخشهایی به صورت برجسته مشخص شده اند تا شما بتوانید راحت تر به هدف خود دست یابید. شما می توانید اطلاعات این فایل را تغییر داده و یا توسط این ابزار آنها را چک کنید. البته فراموش نکنید که لازم است بعد از اعمال تغییرات نسخه تغییر یافته را در سرور آپلود کنید تا تاثیرات مربوط به آن در سایت ظاهر شوند.

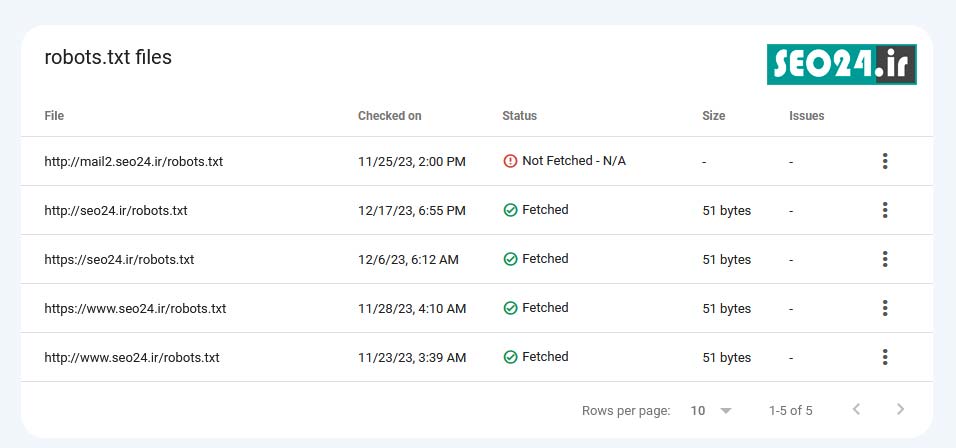

بعد از کلیک بر روی گزارش سرچ کنسول، در صورتی که سرچ کنسول را به صورت domain property تعریف کرده باشید، فهرست فایلهای robotx.txt برای شما نمایش داده میشود.

در صورتی به هر دلیلی روبات گوگل توانایی مشاهده فایل شما را نداشته باشد یا فایل روبات را آپلود نکرده باشید در این بخش خطای مورد نظر را دریافت میکنید. همچنین با کلیک بر روی هر کدام از فایلها محتوای داخل آن قابل مشاهده است.

با کلیک بر روی آیکون سه نقطه در سمت راست گزارش میتوانید به گوگل درخواست بررسی مجدد فایل روبات را بدهید.

علاوه بر آن شما می توانید نسخه های قدیمی تر را بررسی کرده و مواردی که مانع شدند تا خزنده مطالب سایت را به درستی بیابد، پیدا کنید. برای مثال اگر ربات گوگل برای فایل robots.txt با خطای ۵۰۰سرور مواجه شد می توانیم از ادامه ی فعالیت خزنده در سایت تا زمان برطرف شدن مشکل جلوگیری کنیم.

پیشنهاد می شود هر زمان که خطا و هشداری برای سایت خود دریافت کردید ابتدا فایل robots.txt مربوطه را مجدد چک کنید. برای مثال شما می توانید از ابزار به روز رسانی گوگل برای ارائهی صفحات مهم سایت خود استفاده کنید و اگر آدرس مسدودی گزارش شده بود با استفاده از تستر فایل robots.txt دلیل بسته شدن آن را ردیابی کرده و مشکل را برطرف کنید. خطایی که معمولا گزارش می شود مربوط به فایلهای قدیمی تر است که اسکریپت های جاوا یا CSS ها را بلاک کرده است. شما با بررسی دقیق گزارشات و وضعیت فایل می توانید مشکل را برطرف کنید.

با تشکر بسیار سایت بسیار مفیدیهممنون